第九届全国激光雷达大会点云数据智能解析比赛规则

一、简介

在国家大力推进基础设施建设,加快生态文明建设,不断提升城市治理水平的背景下,以点云数据为代表的三维空间技术蓬勃发展,凭借其高精度、多维度的特点,广泛应用至各行各业各领域。在交通领域,借助道路点云数据,能够有效增强对3D道路交通场景基础设施、交通参与者、车道线等路面标识以及其他道路交通安全设施的识别、理解、重建与应用,为智慧交通和智慧城市发展提供有力支撑。同时,点云数据也在铁路运输行业展现出卓越性能,能够为铁轨、围栏等铁路基础设施的精细化建模、日常维护与安全运营提供有力保障。此外,城市行道树对减缓气候变化、提升城市生态环境质量等具有重要意义,依托城市行道树点云数据,能够高质量获取单木高程、胸径等基础数据,实现更加精准的单木体积和碳储量的测算。综上所述,点云数据在智慧城市、自动驾驶、铁路运输、生态环保等诸多领域发挥着至关重要的作用,已成为场景理解的核心支撑与关键驱动力量。基于此,本次比赛旨在汇聚研究人员和从业人员,搭建交流平台,推动点云处理技术的突破与应用,为各行各领域注入创新活力。

二、大赛组织

(一)主要组织者

温程璐:厦门大学教授,研究方向包括三维视觉、点云智能处理以及多模态融合感知及其在智能交通系统、地理空间信息、机器人技术等领域的应用。

米晓新:武汉理工大学计算机与人工智能学院副研究员。研究方向为三维计算机视觉与城市理解的交叉领域,包括场景理解与建模、点云处理及其在智能交通系统(ITS)中的应用。

(二)协办人员

曹臻:武汉大学测绘遥感信息工程全国重点实验室博士研究生。研究方向为三维计算机视觉、点云补全和场景理解。

刘翀:武汉大学测绘遥感信息工程全国重点实验室博士研究生。研究方向为点云处理和智能交通系统。

邱博:武汉大学测绘遥感信息工程全国重点实验室硕士研究生。研究方向为三维计算机视觉及其在智能交通系统中的应用。

丁瑞飞:武汉大学测绘遥感信息工程全国重点实验室博士研究生。研究方向为三维计算机视觉及其在城市林业管理中的应用。

夏启明:厦门大学博士研究生。研究方向为三维计算机视觉及其在智能交通系统中的应用。

黄勋:厦门大学博士研究生。研究方向为三维计算机视觉及其在智能交通系统中的应用。

叶伟:厦门大学硕士研究生。研究方向为三维计算机视觉及其在智能交通系统中的应用。

张桓佳:厦门大学硕士研究生。研究方向为三维计算机视觉及其在智能交通系统中的应用。

三、赛程安排

(一)参赛报名(自该通知发布后至北京时间2025年8月10日23:59)

参赛者可以以个人或团队名义参赛,在会议网站(http://lidar2025wuhan.com)下载比赛报名表(见附件1),填写相关信息并发送至大赛指定邮箱(lidar2025@163.com),待收到确认邮件(含数据下载链接)回复后即可确认报名成功。

(二)提交截止时间(北京时间2025年9月3日23:59)

各参赛团队根据所选赛道,依托大赛组委会所提供的比赛数据进行高效算法或后处理方法设计,根据相应赛道要求提交比赛结果。

(三)结果公布时间(2025年9月10日)

比赛结果提交后,比赛组委会将使用自动化程序进行结果评估并组织专家对最终结果进行评审,公布最终获奖名单。

四、赛道规则

(一)赛道一:城市道路场景点云语义/实例分割

1、任务描述

参赛者需开发城市点云的语义和实例分割算法,重点关注复杂城市环境中的准确物体描绘以及车辆、人等19个语义类别中各种城市元素的可靠检测。

2、数据集介绍

本赛道使用WHU-Urban3D数据集。该数据集广泛覆盖机载和移动激光扫描点云数据,为3D深度学习算法的进步提供了一个独特且极具挑战性的平台。该数据集源自中国城市,城市场景的复杂性和多样性极高,旨在弥补高质量数据集的匮乏与现实世界户外环境中对3D场景理解日益增长的需求之间的差距。通过提供标注丰富、内容丰富的数据集,我们希望鼓励研究人员探索新领域,突破3D深度学习应用的界限,从而为先进的研究开辟广阔的前景。详见网站(https://whu3d.com)

3、评估指标

参照以下MUConv、MWCov、Pre、Rec、F1、oAcc、mAcc、mIoU评估指标,具体含义详见论文《WHU-Urban3D: An urban scene LiDAR point cloud dataset for semantic instance segmentation》

4、操作说明

(1)在训练数据集上开发3D语义、实例分割模型。

(2)使用优化的模型来预测测试数据集上的结果。

(3)提交您的结果至指定网站(https://www.codabench.org/competitions/7197/),网站将对您的提交进行自动评估,并实时展示评估结果。

5、提交方式

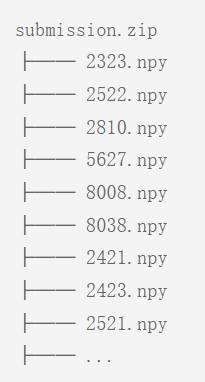

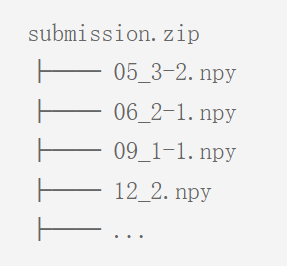

在本次比赛中,参赛者必须为数据集测试集的每个点提供语义标签和实例标签。因此,参赛方法的输入都是3D点的坐标列表及其属性(每个点的反射强度值)。之后,每种方法都应为每个点输出一个语义标签和一个实例标签,用于最终的性能评估。您必须提供包含标签的单个zip文件,其中的内容须按如下方式组织:

注:

.npy文件是一个bin文件,提供每个点的标签预测,数据类型为uint8。每个.npy文件中应存储一个N*2的数组,其中N是对应点云中的点数,第一列是实例ID,第二列是语义类别。

如有疑问,请发邮件咨询:liuchongwhu@whu.edu.cn

(二)赛道二:铁路场景点云语义分割

1、任务描述

参赛者需要为铁路点云开发语义分割模型,对涵盖不同铁路环境中的铁路基础设施、建筑结构和自然元素的11类别进行分类,解决遮挡和类别不平衡等挑战。数据集包含城市铁路、农村铁路和高原铁路三类典型场景,参赛者需同时处理三类不同场景的铁路点云。

2、数据集介绍

本赛道使用WHU-Railway3D数据集。该数据集是一个专为铁路场景定制的多样化点云语义分割数据集。该数据集覆盖约30公里,包含46亿个点,涵盖城市、农村和高原铁路环境,提供了11种类别的精细标注(包括铁轨、道床、支柱钢架、支撑装置、接触网、围栏、杆状物、植被、建筑物、地面、其他)。除了3D坐标外,该数据集还提供了丰富的属性信息,例如反射强度、扫描角度和回波次数等。详见网站(https://github.com/WHU-USI3DV/WHU-Railway3D)

3、评估指标

平均交并比 (mIoU)、逐类别的交并比IoU、总体准确度 (OA) 。详见论文《WHU-Railway3D: A Diverse Dataset and Benchmark for Railway Point Cloud Semantic Segmentation》

4、操作说明

(1)在训练数据集上开发您的3D语义分割模型。

(2)使用优化的模型来预测测试数据集上的结果。

(3)提交您的结果至指定网站,网站将对您的提交进行自动评估,并实时展示评估结果。

城市铁路:https://www.codabench.org/competitions/5138/

农村铁路:https://www.codabench.org/competitions/5140/

高原铁路:https://www.codabench.org/competitions/5142/

5、提交方式

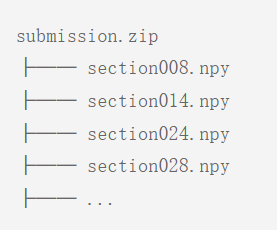

(1)城市铁路数据集

在本任务中,参赛者必须为数据集测试集的每个点提供语义标签。因此,参赛者需要为每个点预测一个语义标签,用于最终的分割性能评估。您必须提供包含标签的单个zip文件。zip文件的内容应按如下方式组织:

注:训练集和测试集共包含11个语义类别,包括铁轨、道床、支柱钢架、支撑装置、接触网、围栏、杆状物、植被、建筑物、地面、其他。.npy文件是二进制bin文件,提供逐点的语义标签预测,数据类型为uint8。

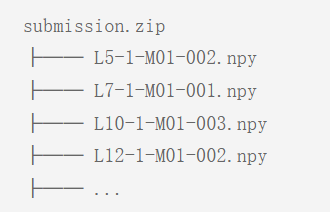

(2)农村铁路数据集

在本任务中,参赛者必须为数据集测试集的每个点提供语义标签和实例标签。因此,所有评估方法的输入都是3D点的坐标列表及其属性,即每个点的反射强度值。之后,每种方法都应为每个点输出一个标签,用于最终的性能评估。您必须提供包含标签的单个zip文件。zip文件的内容应按如下方式组织:

注:训练集和测试集共包含11个语义类别,包括铁轨、道床、支柱钢架、支撑装置、接触网、围栏、杆状物、植被、建筑物、地面、其他。.npy文件是二进制bin文件,提供逐点的语义标签预测,数据类型为uint8。

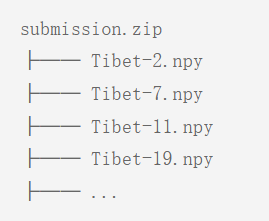

(3)高原铁路数据集

在本任务中,参赛者必须为数据集测试集的每个点提供语义标签。因此,所有评估方法的输入都是3D点的坐标列表及其属性,即每个点的反射强度值。之后,每种方法都应为每个点输出一个标签,用于最终的性能评估。您必须提供包含标签的单个zip文件。zip文件的内容应按如下方式组织:

注:训练集和测试集共包含8个语义类别,包括铁轨、道床、接触网、围栏、杆状物、建筑物、地面、其他。.npy文件是二进制bin文件,提供逐点的语义标签预测,数据类型为uint8。

如有疑问,请发邮件咨询:traffic3dchallenge@outlook.com

(三)赛道三:城市道路场景单木分割

1、任务描述

参赛者需开发城市道路场景单木分割算法,能够实现城市行道树的精准定位和分割,为城市绿化规划建设、碳储量估计提供支撑。

2、数据集介绍

本赛道采用WHU-STree数据集。该数据集整合了两座分属不同气候区的城市的车载点云和街景影像数据,覆盖道路约66公里,包含21007个树实例,涵盖50多个丰富的树木类别以及2种形态参数(树高和胸径)。数据集跨城市覆盖、丰富标注、多模态数据的特点,使其能够支撑多种相关行道树研究,包括单木分割、树种分类、单目/多目形态参数估计等。详见网站:(https://github.com/WHU-USI3DV/WHU-STree)

3、评价指标

实例级指标:精度(Prec)、召回(Rec)(IoU阈值0.75)

点级指标:覆盖度(Cov)和加权覆盖度(WCov)

4、操作说明

(1)在训练数据集上开发单木分割算法(可为非深度学习算法)。

(2)使用开发的算法来预测测试数据集上的结果。

(3)提交您的结果至指定网站(https://www.codabench.org/competitions/8821/),网站将对您的提交进行自动评估,并实时展示评估结果。

5、提交方式

在本任务中,参赛者必须为数据集测试集的每个点提供实例ID。因此,所有评估方法的输入是点云或点云+影像,且赛会鼓励多模态算法的开发。之后,每种方法都应为每个点输出一个标签,用于最终的性能评估。您必须提供包含标签的单个zip文件。zip文件的内容应按如下方式组织:

注:

.npy文件是一个bin文件,提供每个点的标签预测,数据类型为int16。每个.npy文件严格以“道路编号_点云编号.npy”的形式命名。每个.npy文件中应存储一个N*1的数组,其中N是对应点云中的点数,列数据为预测的实例ID。

如有疑问,请发邮件咨询:dingrf@whu.edu.cn

(四)赛道四:城市道路车道线提取与矢量化

1、任务描述

参赛者需开发算法直接从MLS点云中提取车道线及其语义属性,重点是创建几何精确、拓扑一致的矢量车道线,突破在复杂交叉路口、车道数量变化、车道线语义变化、数据空洞等挑战场景。

2、数据集介绍

本赛道使用WHU-Lane数据集为训练集详见网站(https://github.com/WHU-USI3DV/LaneMapping),新采集的车载激光点云数据WHU-Lane-test为比赛数据集(下载链接: https://pan.baidu.com/s/1vQb-DVOWS9dzW78ofOkrvQ?pwd=4j2m 提取码: 4j2m),该数据集是一个多样化点云车道测绘数据集,覆盖范围约6公里,包含数十亿个点。除了3D坐标外,它还提供强度信息,以便更好地提取车道线。

测试数据中已包括根据Las2BEV项目(https://github.com/MIXIAOXIN/Las2BEV)获得的路面BEV图像,预测出的BEV图像上的点反算至点云的代码见LaneMapping项目(LaneMapping/baseline/utils/coor_img2pc.py):

3、评估指标

我们在训练和测试中总共使用了2个语义类别,包括Solid_lane和Dashed_lane。我们通过以下方式评估输出:平均准确率(Prec)、召回率(Rec)、F1分数、几何相似性(FD),详见论文《A Benchmark Approach and Dataset for Large-scale Lane Mapping from MLS Point Clouds》,缓冲半径为0.3米。

4、操作说明

(1)在训练数据集上开发您的车道线提取模型。

(2)使用优化的模型来预测测试数据集上的结果。

(3)提交您的结果至指定网站(https://www.codabench.org/competitions/8771/),网站将对您的提交进行自动评估,并实时展示评估结果。

5、提交方式

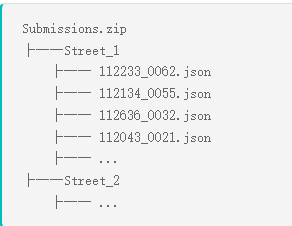

在本赛道中,参赛者需要为数据集测试集的每个车道线提供车道线上的点三维坐标、语义标签,用于最终的性能评估。您必须提供包含json文件的单个zip文件。zip文件的内容应按如下方式组织:

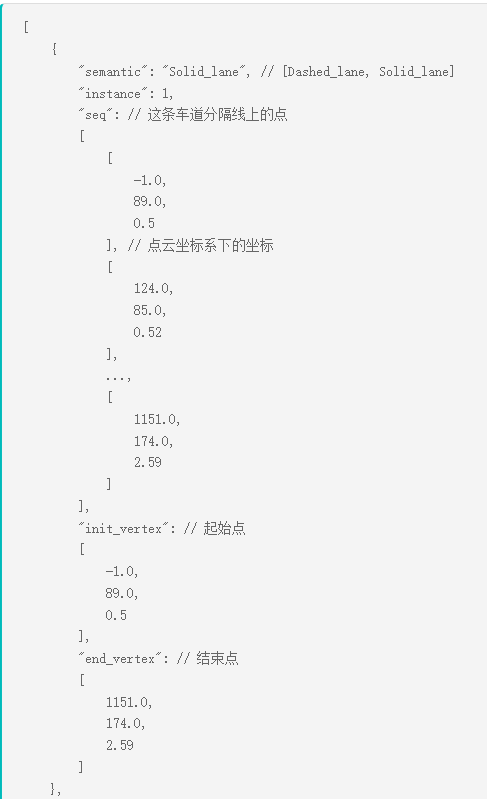

.json 文件提供了预测出的每条车道上的点三维坐标、语义标签。对于112233_0062.json,其预测结果可能是:

如有疑问,请发邮件咨询:zhen.cao@whu.edu.cn

(五)赛道五:跨体制激光雷达传感器域适应目标检测

1、任务描述

参赛者需在128线或32线机械式激光雷达的点云数据上训练检测器,并且在没有任何目标域标签的情况下,将它们泛化到一个隐藏的固态激光雷达测试集上,用于跨机制域适应的三维目标检测。

2、数据集介绍

CMD数据集(https://github.com/im-djh/CMD/blob/master/docs/competitiontrack.md)包含三种经过良好同步和精确校准的激光雷达机制——128线机械式、32线机械式以及固态/半固态激光雷达。每个传感器采集了10,000帧数据(50个序列,每个序列20秒,采样频率为10Hz)。数据涵盖了丰富多样的环境,包括城市、郊区、乡村、高速公路、桥梁、隧道和校园场景,并且在五种光照条件下进行采集,范围从明亮的白天到黄昏。

3、评估指标

在四个类别(汽车、卡车、行人、骑自行车者)上的平均精度均值(Mean Average Precision,mAP)。每个类别的平均精度(AP)作为补充分数进行报告(汽车和卡车的交并比IoU阈值为0.5,行人和骑自行车者的IoU阈值为0.25)。

4、操作说明

(1)在训练数据集上开发您的目标检测模型。

(2)使用优化的模型来预测测试数据集上的结果。

(3)提交您的结果至指定网站(https://www.codabench.org/competitions/7749/),网站将对您的提交进行自动评估,并实时展示评估结果。

5、提交方式

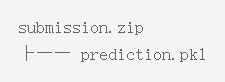

您需要提供一个包含预测结果的单一压缩包(zip 文件)。该压缩包的内容应按照以下结构组织:

关于生成 .pkl 文件的详细方法,请参阅 https://github.com/im-djh/CMD/blob/master/docs/competitiontrack.md。

如有疑问,请发邮件咨询:xiaqiming@stu.xmu.edu.cn

(六)赛道六:激光雷达-毫米波雷达融合的协同感知任务

1、任务描述

参赛者需要使用多模态数据源中的协同感知数据来训练一个三维目标检测器,这些数据源包括激光雷达(LiDAR)点云和4D雷达点云。检测器应能够在协同感知场景中成功识别感兴趣的目标,并输出它们的8维属性,这些属性包括目标的长度、宽度、高度、三维坐标、方向角以及类别。

2、数据集介绍

V2X-R数据集(https://github.com/ylwhxht/V2X-R/tree/Challenge2025)涵盖了大量模拟的城市道路,包含 12,079 个 V2X(车联网)场景,这些场景被划分为 8,084 个训练帧、829 个验证帧 和 3,166 个测试帧。每个场景包含 37,727 帧激光雷达点云 和 4D 毫米波雷达点云,以及 170,859 个标注的三维车辆边界框。在每个 V2X 场景中,互联代理(包括车辆和基础设施)的数量最少为 2 个,最多为 5 个。

3、评估指标

总体平均精度(Average Precision, AP)将被用作主要排名指标,其交并比(Intersection over Union, IoU)阈值为 0.7。此外,还会评估不同距离范围(0-30 米、30-50 米、50 米至无穷远)的 AP。评估类别为“车辆”,结果需在“本车”(ego)摄像头的视野范围(Field of View, FOV)内,且在 x ∈ [0, 140] 米和 y ∈ [-40, 40] 米的范围内。互联代理的广播范围为 70 米。

4、操作说明

(1)在训练数据集上开发您的目标检测模型。

(2)使用优化的模型来预测测试数据集上的结果。

(3)提交您的结果至指定网站(https://www.codabench.org/competitions/7754/),网站将对您的提交进行自动评估,并实时展示评估结果。

5、提交方式

您需要提供一个包含预测结果的单一压缩包(zip 文件)。该压缩包的内容应按照以下结构组织:

关于生成 .pkl 文件的详细方法,请参阅 https://github.com/ylwhxht/V2X-R/tree/Challenge2025。

如有疑问,请发邮件咨询:xiaqiming@stu.xmu.edu.cn

五、奖项设置

第九届全国激光雷达大会点云数据智能解析比赛每个赛道分设特、一、二等奖,颁发获奖证书及奖金。

六、其他

本通知所涉及内容的最终解释权,归第九届全国激光雷达大会点云数据智能解析比赛组委会所有。

七、联系方式

大赛组委会

联系电话:182-0277-6979

邮箱:lidar2025@163.com

附件: